8 december (Reuters) – De EU-rechtenwaakhond heeft donderdag gezegd dat toepassingen die kunstmatige intelligentie (AI) gebruiken om criminaliteit te voorspellen en online haatzaaiende uitspraken te matigen, vrij van vooroordelen moeten zijn om discriminatie te voorkomen.

In een rapport dat is gebaseerd op een studie uit 2021, zegt het in Wenen gevestigde EU-agentschap voor de grondrechten (FRA) dat algoritmen die zijn gebaseerd op slechte gegevenskwaliteit het leven van mensen kunnen schaden.

De studie komt tegen de achtergrond van de voorgestelde AI-wet van de Europese Commissie, die kritiek kreeg van wetgevers en consumentengroepen uit EU-landen omdat de risico’s van AI-systemen die de grondrechten zouden kunnen schenden, niet volledig worden aangepakt.

“We hebben een systeem nodig voor het beoordelen en beperken van vooroordelen vóór en tijdens het gebruik van algoritmen om mensen te beschermen tegen discriminatie”, zei FRA-directeur Michael O’Flaherty.

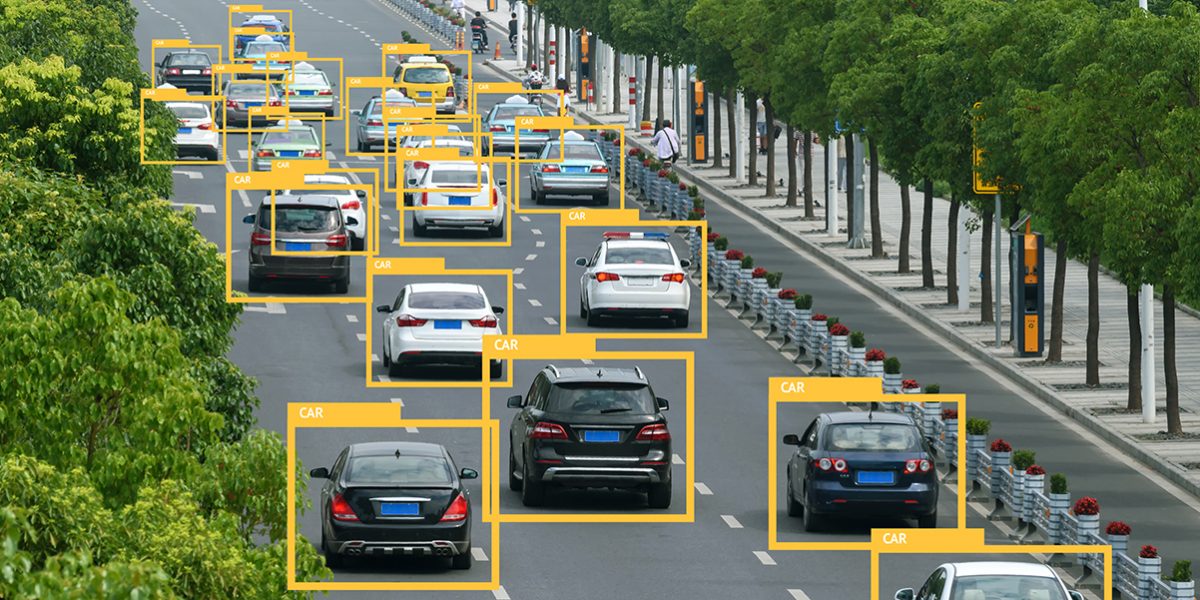

Misdaaddetectie varieert en kan de gegevens beïnvloeden, aldus FRA, omdat bepaalde misdaden gemakkelijk te detecteren zijn terwijl voorspellingen zich te veel richten op misdaden die voor de politie gemakkelijker te registreren zijn.

Als gevolg daarvan kunnen sommige demografische groepen vaker in verband worden gebracht met “eenvoudigere misdrijven”, wat kan leiden tot vooroordelen bij de rechtshandhaving, aldus FRA.

Wat de moderatie van beledigende taal betreft, vond het bureau de algoritmen die waren ontwikkeld voor de automatische opsporing van haatzaaiende taal onbetrouwbaar omdat zij niet-aanstootgevende termen in het Engels die verwijzen naar “moslim”, “homo” of “jood” als beledigend aanmerkten.

Ook sommige algoritmen in het Duits en Italiaans, die geslachtsgebonden zelfstandige naamwoorden gebruiken, vonden de vrouwelijke versie van een term beledigender dan de mannelijke, of omgekeerd.

FRA zei dat de voorspellingen van de algoritmen de neiging hebben te overreageren omdat ze gekoppeld zijn aan online haat in haar tekstdatasets.